Thế giới các nhà nghiên cứu phát triển AI trong những năm gần đây đều đã tập trung vào việc phát triển AI tạo sinh, để chúng vượt qua những bài kiểm tra mà con người đặt ra để đo đạc sức mạnh trí tuệ nhân tạo. Bài kiểm tra Turing nổi tiếng đã bị các mô hình AI "vượt qua" ở một mức độ nào đó. Và tranh cãi nảy lửa xoay quanh việc liệu các mô hình mới nhất có đang được xây dựng để gian lận các tiêu chuẩn benchmark vốn có hay không.

Vấn đề nằm ở chỗ, theo các học giả tại DeepMind của Google, không phải là yêu cầu từ các bài kiểm tra, mà là cách giới hạn trong việc phát triển các mô hình AI. Dữ liệu được sử dụng để huấn luyện AI đang bị hạn chế vô cùng, và đều là những dữ liệu tĩnh. Theo họ, những dữ liệu huấn luyện này sẽ không bao giờ thúc đẩy AI đạt được những khả năng mới và tốt hơn.

Trong một báo cáo nghiên cứu khoa học được DeepMind công bố tuần trước, dự kiến sẽ được đăng trong một cuốn sách sắp xuất bản của MIT Press, các nhà nghiên cứu đề xuất rằng AI phải được phép có "kinh nghiệm" theo một cách nào đó. Nó phải được phép tương tác với thế giới để hình thành mục tiêu dựa trên tín hiệu từ môi trường.

“Những khả năng mới đáng kinh ngạc sẽ xuất hiện, khi toàn bộ tiềm năng của việc học hỏi thông qua trải nghiệm được khai thác,” các học giả DeepMind David Silver và Richard Sutton viết trong bài nghiên cứu khoa học có tên "Chào mừng đến với Kỷ nguyên trải nghiệm".

Hai học giả này là những huyền thoại đúng nghĩa trong lĩnh vực trí tuệ nhân tạo.

David Silver

David Silver chính là nhà nghiên cứu nổi tiếng, từng dẫn đầu nhóm nghiên cứu tạo ra AlphaZero, mô hình AI của DeepMind đã đánh bại con người trong các trò chơi cờ vua và cờ vây. Còn Richard Sutton là một trong hai nhà khoa học máy tính đã đoạt giải thưởng Turing, nhờ việc phát minh ra một phương pháp phát triển AI rất quen thuộc, được gọi là học tăng cường (reinforcement learning), thứ mà Silver và nhóm của ông đã sử dụng để tạo ra AlphaZero.

Phương pháp mới mà hai học giả này đề xuất xây dựng dựa trên học tăng cường và những bài học từ AlphaZero. Nó được gọi là "luồng" (streams), nhằm khắc phục những thiếu sót của các mô hình ngôn ngữ lớn hiện tại, vốn chỉ được phát triển để trả lời các câu hỏi cụ thể của con người.

Silver và Sutton cho rằng, ngay sau khi AlphaZero và tiền thân của nó, AlphaGo, xuất hiện, các công cụ AI tạo sinh như ChatGPT đã "bỏ qua" bước học tăng cường. Động thái này có cả lợi ích và hạn chế. AI tạo sinh là một bước tiến quan trọng, vì việc sử dụng học tăng cường của AlphaZero bị giới hạn trong các ứng dụng hạn chế. Công nghệ không thể vượt ra ngoài các trò chơi với "thông tin và luật lệ đầy đủ" như cờ vua, nơi tất cả các quy tắc đều vô cùng rõ ràng.

Richard Sutton

Mặt khác, mô hình AI tạo sinh có thể xử lý dữ liệu đầu vào tự phát từ con người, những thứ AI chưa từng gặp trước đây, mà không có các quy tắc rõ ràng về cách mọi thứ phải diễn ra. Tuy nhiên, việc bỏ qua học tăng cường đồng nghĩa với việc "mất đi một điều gì đó trong quá trình chuyển đổi này: khả năng tự khám phá kiến thức của một tác nhân," họ viết.

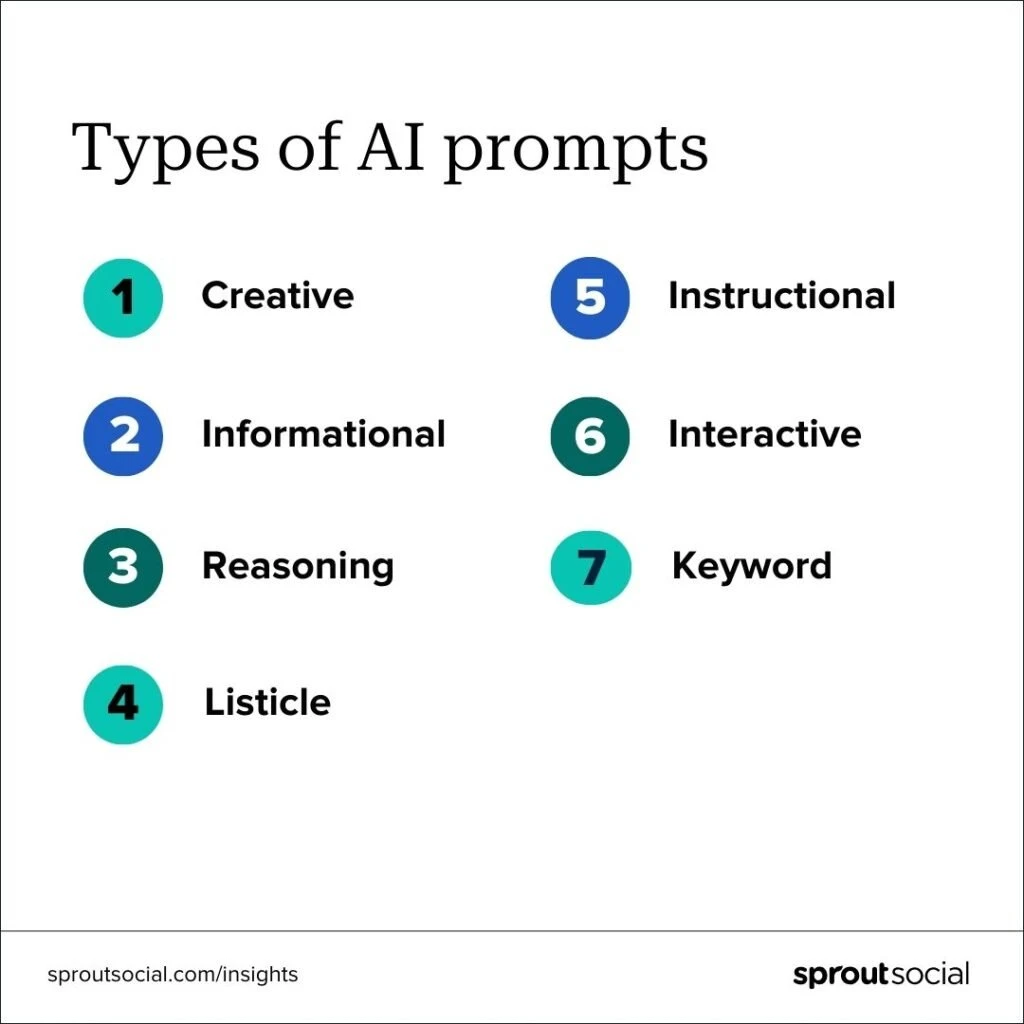

Thay vào đó, họ nhận thấy rằng LLM giờ đều phải "dựa trên phán đoán của con người", hoặc những gì con người muốn ở giai đoạn ra lệnh prompt. Cách tiếp cận này, theo họ, quá hạn chế. Họ cho rằng phán đoán của con người "áp đặt một giới hạn không thể vượt qua đối với hiệu suất của tác nhân: Tác nhân AI không thể khám phá ra các chiến lược tốt hơn mà người đánh giá là con người chưa đánh giá cao."

Không chỉ phán đoán của con người là một trở ngại, mà bản chất ngắn gọn và cắt đứt của các tương tác tạo prompt cũng không cho phép mô hình AI tiến xa hơn câu hỏi và trả lời.

Hai nhà nghiên cứu viết: "Trong kỷ nguyên dữ liệu của con người, AI dựa trên ngôn ngữ chủ yếu tập trung vào các tập đoạn tương tác ngắn: ví dụ: một người dùng đặt câu hỏi và (có thể sau một vài bước suy nghĩ hoặc hành động sử dụng công cụ) tác nhân phản hồi. Tác nhân AI nhắm đến kết quả trong hiện tại, chẳng hạn như trả lời trực tiếp câu hỏi của người dùng." Không có bộ nhớ, không có sự liên tục giữa các đoạn tương tác trong câu prompt. "Thông thường, rất ít hoặc không có thông tin được truyền qua từ một tập đoạn sang tập đoạn khác, ngăn cản mọi sự thích ứng theo thời gian," Silver và Sutton viết.

Tuy nhiên, trong Kỷ nguyên Trải nghiệm mà họ đề xuất, "Các tác nhân AI sẽ cư ngụ trong các luồng kinh nghiệm, thay vì các đoạn tương tác ngắn."

Silver và Sutton vẽ ra một phép so sánh giữa các luồng và việc con người học hỏi thông qua cả một đời sống tích lũy kinh nghiệm, và cách họ hành động dựa trên các mục tiêu dài hạn, không chỉ là nhiệm vụ trước mắt: “Các tác nhân AI mạnh mẽ nên có luồng kinh nghiệm tự tiến bộ của riêng chúng, giống như con người, trong một khoảng thời gian dài.”

Silver và Sutton lập luận rằng "công nghệ hiện tại" đã đủ để bắt đầu xây dựng các luồng trải nghiệm. Trên thực tế, những bước đi ban đầu có thể được nhìn thấy trong các phát triển như các tác nhân AI duyệt web, bao gồm Deep Research của OpenAI.

"Gần đây, một làn sóng các tác nhân AI mới bắt đầu tương tác với máy tính theo cách tổng quát hơn, bằng cách sử dụng cùng một giao diện mà con người sử dụng để điều khiển máy tính," họ viết. Tác nhân AI tích hợp trong trình duyệt web đã đánh dấu

"sự chuyển đổi từ giao tiếp được ưu tiên tuyệt đối bởi con người sang các tương tác nơi AI tự chủ hơn, nơi tác nhân có thể hành động độc lập trong thế giới."

Khi các tác nhân AI vượt ra ngoài việc chỉ duyệt web, họ cần một cách để tương tác và học hỏi từ thế giới. Họ đề xuất rằng các tác nhân AI trong luồng sẽ học thông qua cùng nguyên tắc học tăng cường như AlphaZero. Máy móc được cung cấp một mô hình về thế giới mà nó tương tác, giống như bàn cờ vua, và một bộ quy tắc. Khi tác nhân AI khám phá và thực hiện hành động, nó nhận được phản hồi dưới dạng "phần thưởng". Những phần thưởng này huấn luyện mô hình AI về những thứ ít hoặc nhiều giá trị trong một tình huống nhất định.

Thế giới đầy những "tín hiệu" khác nhau cung cấp những phần thưởng đó, nếu tác nhân được phép tìm kiếm chúng:

"Phần thưởng đến từ đâu, nếu không phải từ dữ liệu của con người? Khi các tác nhân kết nối với thế giới thông qua các không gian hành động và quan sát phong phú, sẽ không có sự thiếu hụt tín hiệu nền tảng để cung cấp cơ sở cho phần thưởng.

Trên thực tế, thế giới tràn ngập các trọng số như chi phí, tỷ lệ lỗi, đói, năng suất, chỉ số sức khỏe, chỉ số khí hậu, lợi nhuận, doanh số, kết quả thi, thành công, lượt truy cập, năng suất, cổ phiếu, thích, thu nhập, khoái/đau, chỉ số kinh tế, độ chính xác, năng lượng, khoảng cách, tốc độ, hiệu quả hoặc tiêu thụ năng lượng. Ngoài ra còn có vô số tín hiệu bổ sung phát sinh từ sự xuất hiện của các sự kiện cụ thể, hoặc từ các tính năng được suy luận từ chuỗi quan sát và hành động thô."

Để bắt đầu vận hành tác nhân AI từ một nền tảng vững chắc, các nhà phát triển AI có thể sử dụng mô phỏng "mô hình thế giới". Mô hình thế giới cho phép mô hình AI đưa ra dự đoán, kiểm tra những dự đoán đó trong thế giới thực và sau đó sử dụng các tín hiệu phần thưởng để làm cho mô hình trở nên thực tế hơn. “Khi tác nhân tiếp tục tương tác với thế giới trong suốt luồng kinh nghiệm của mình, mô hình động lực học của nó được cập nhật liên tục để sửa bất kỳ lỗi nào trong dự đoán của nó."

Silver và Sutton vẫn kỳ vọng con người sẽ có vai trò trong việc xác định mục tiêu, cả tín hiệu và phần thưởng phục vụ để điều hướng tác nhân AI. Ví dụ, một người dùng có thể chỉ định một mục tiêu rộng như 'cải thiện sức khỏe thể chất', và hàm phần thưởng có thể trả về một hàm của nhịp tim, thời lượng giấc ngủ và số bước đi của người dùng. Hoặc người dùng có thể chỉ định một mục tiêu là 'giúp tôi học tiếng Tây Ban Nha', và hàm phần thưởng có thể trả về kết quả thi tiếng Tây Ban Nha của người dùng.

Phản hồi của con người trở thành "mục tiêu cấp cao nhất" mà tất cả đều sẽ phải phục vụ.

Các nhà nghiên cứu viết rằng, các tác nhân AI với những khả năng dài hạn sẽ giúp các công cụ trợ lý AI vận hành hiệu quả và có ích hơn. Những trợ lý ảo này có thể theo dõi giấc ngủ và chế độ ăn uống của một người trong nhiều tháng hoặc nhiều năm, cung cấp lời khuyên về sức khỏe mà không bị giới hạn ngữ cảnh ở các xu hướng gần đây. Các tác nhân AI này cũng có thể là trợ lý giáo dục theo dõi học sinh trong một thời gian dài.

Xa hơn, các nhà nghiên cứu cho rằng: "Một tác nhân AI nghiên cứu khoa học có thể theo đuổi các mục tiêu tham vọng, chẳng hạn như khám phá vật liệu mới hoặc giảm lượng khí carbon dioxide. Tác nhân đó có thể phân tích các quan sát thực tế trong một khoảng thời gian kéo dài, phát triển và chạy mô phỏng, đồng thời đưa ra các thử nghiệm hoặc can thiệp thực tế."

Các nhà nghiên cứu cho rằng, sự xuất hiện của các mô hình AI "tư duy" hoặc "suy luận", chẳng hạn như Gemini của Google, R1 của DeepSeek và o1 của OpenAI, chúng hoàn toàn có thể bị vượt qua bởi các tác nhân AI có kinh nghiệm. Vấn đề với các tác nhân lý luận là chúng "mô phỏng" ngôn ngữ của con người khi tạo ra đầu ra dài dòng về các bước để trả lời, và suy nghĩ của con người có thể bị giới hạn bởi những giả định tiềm ẩn của nó.

"Ví dụ, nếu một tác nhân được huấn luyện để suy luận bằng cách sử dụng suy nghĩ của con người và câu trả lời chuyên gia từ 5.000 năm trước, nó có thể đã lý luận về một vấn đề vật lý theo các thuật ngữ của chủ nghĩa linh hồn. 1.000 năm trước, nó có thể đã lý luận theo các điều khoản tôn giáo; 300 năm trước, nó có thể đã lý luận theo các điều khoản của cơ học Newton. Và 50 năm trước, nó có thể suy luận theo quy luật cơ học lượng tử."

Các nhà nghiên cứu viết rằng những tác nhân đó "sẽ mở khóa những khả năng chưa từng có," dẫn đến "một tương lai rất khác biệt so với bất cứ điều gì chúng ta đã thấy trước đây."

Tuy nhiên, họ cho rằng tương lai này cũng sẽ có nhiều rủi ro. Những rủi ro này không chỉ tập trung vào việc các tác nhân AI làm cho năng suất lao động của con người trở nên lỗi thời, mặc dù họ lưu ý rằng tình trạng thất nghiệp vẫn sẽ là một rủi ro. Các tác nhân AI "có thể tương tác tự chủ với thế giới trong một thời gian dài để đạt được các mục tiêu dài hạn," họ viết, đặt ra triển vọng con người có ít cơ hội hơn để "can thiệp và điều hòa hành động của tác nhân."

Về mặt tích cực, họ gợi ý rằng một tác nhân có thể thích ứng, trái ngược với các mô hình AI cố định ngày nay, "có thể nhận ra khi hành vi của nó đang gây ra sự lo lắng, không hài lòng hoặc đau khổ của con người, và điều chỉnh hành vi của chúng để tránh những hậu quả tiêu cực."

Bỏ qua chi tiết, Silver và Sutton tin rằng luồng học hỏi kinh nghiệm sẽ tạo ra rất nhiều thông tin hơn về thế giới, sẽ vượt xa tất cả nguồn dữ liệu Wikipedia và Reddit được sử dụng để huấn luyện AI ngày nay. Các tác nhân AI dựa trên luồng học kinh nghiệm thậm chí có thể vượt qua trí thông minh của con người, ám chỉ sự xuất hiện của trí tuệ nhân tạo tổng quát, hoặc AGI.

Cuối cùng, trong bài nghiên cứu, hai nhà khoa học AI viết: "Dữ liệu kinh nghiệm sẽ vượt quá quy mô và chất lượng của dữ liệu do con người tạo ra. Sự thay đổi mô hình này, cùng với những tiến bộ về thuật toán trong kỹ thuật học tăng cường, sẽ mở khóa nhiều khả năng mới trong nhiều lĩnh vực vượt qua những khả năng mà bất kỳ con người nào sở hữu."

Theo ZDNet Nguồn:tinhte.vn/thread/google-deepmind-o-ky-nguyen-trai-nghiem-ai-se-tu-hoc-khong-can-prompt-hay-du-lieu-huan-luyen.4012479/