Tại Cloud Next 2025, Google công bố Ironwood – Tensor Processing Unit (TPU) thế hệ thứ 7, bộ tăng tốc AI tùy chỉnh mạnh nhất, mở rộng nhất và tiết kiệm năng lượng nhất từ trước đến nay, được thiết kế đặc biệt cho suy luận (inference). Kèm theo đó là các mô hình AI mới như Gemini 2.5 Flash, Lyria, Veo 2, Imagen 3 và Chirp 3, đánh dấu bước tiến trong hạ tầng AI.

Ảnh chụp màn hình.

Năm ngoái Google đã ra mắt TPU thế hệ 6 là Trillium, năm nay thì thế hệ 7 họ đặt tên là Ironwood. Ironwood cũng đánh dấu sự chuyển dịch từ AI phản hồi (cung cấp thông tin thời gian thực để con người diễn giải) sang AI chủ động (tạo hiểu biết và phân tích). Google gọi đây là “thời đại suy luận”, nơi AI tự động thu thập, xử lý dữ liệu để đưa ra câu trả lời chi tiết.

TPU thế hệ 7 của Google hỗ trợ “mô hình tư duy” như Large Language Models (LLMs), Mixture of Experts (MoEs) và tác vụ suy luận nâng cao, đòi hỏi xử lý song song lớn và truy cập bộ nhớ hiệu quả. Ironwood giảm thiểu di chuyển dữ liệu, độ trễ khi xử lý tensor khổng lồ.

Cấu hình của Ironwood được chia thành hai "phiên bản" để phục vụ cho nhiều nhu cầu xử lý công việc khác nhau dành cho khách hàng của Google Cloud. Một phiên bản sẽ có 256 chip và một phiên bản lớn hơn là 9216 chip (pod). Một pod sẽ có sức mạnh tính toán là 4.25 Exaflops, gấp 24 lần siêu máy tính lớn nhất thế giới - El Capitan (1.7 exaflops mỗi pod). Mỗi chip riêng lẻ có khả năng tính toán đỉnh cao là 4.614 TFLOPs.

Ironwood cũng có băng thông cao và độ trễ thấp, hỗ trợ giao tiếp đồng bộ toàn pod, dùng mạng Inter-Chip Interconnect (ICI) 1,2 Tbps (gấp 1,5 lần Trillium là TPU thế hệ 6). TPU thế hệ 7 của Google cũng có bộ nhớ HBM 192GB (gấp 6 lần Trillium), băng thông 7,2 TBps (gấp 4.5 lần Trillium). Ironwood cũng được trang bị SparseCore, một bộ tăng tốc chuyên dụng để xử lý các embedding siêu lớn thường thấy trong các khối lượng công việc xếp hạng và đề xuất nâng cao.

Hỗ trợ SparseCore mở rộng trong Ironwood cho phép tăng tốc một loạt các khối lượng công việc rộng hơn, bao gồm cả việc vượt ra ngoài lĩnh vực AI truyền thống sang các lĩnh vực tài chính và khoa học.

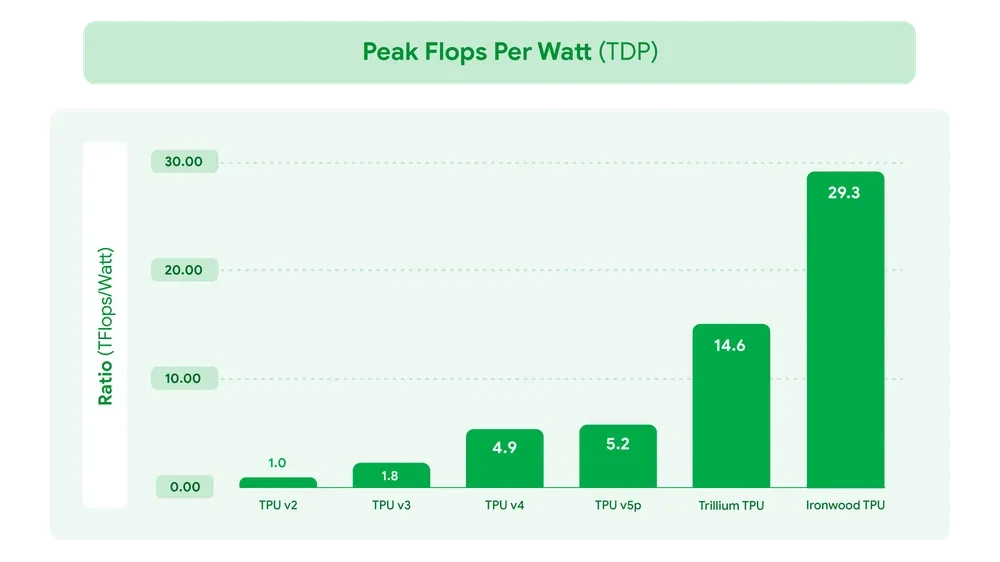

Về hiệu suất năng lượng, Ironwood có performance/watt gấp đôi so với Trillium và gần 30 lần so với TPU thế hệ 2. Ironwood được trang bị công nghệ làm mát bằng chất lỏng, duy trì hiệu năng cao liên tục trong thời gian dài.

Bảng trên là mô tả về hiệu quả tính toán FP8 của Ironwood và nếu lấy TPU thế hệ 2 làm chuẩn (1x) thì TPU thế hệ 7 của Google hiệu quả hơn 3600 lần. Tuy nhiên, biểu đồ này thể hiện hiệu suất của các Pod lớn, không phải của một chip đơn lẻ.

Sau cùng là Google cũng hỗ trợ khả năng mở rộng (Scalability), giúp người dùng Google Cloud dễ dàng tăng cường năng lực xử lý khi nhu cầu tăng lên hoặc khi các mô hình AI trở nên phức tạp hơn. Để làm được điều đó, họ giới thiệu Pathways runtime, một hệ thống phần mềm điều phối và môi trường thực thi (runtime system) chuyên biệt.

Vai trò của nó là chính là bộ não phần mềm quản lý việc phân chia, gửi tác vụ đến từng chip, và tổng hợp kết quả một cách hiệu quả nhất. Khi huấn luyện hoặc chạy inference cho các mô hình AI cực lớn (đặc biệt là Generative AI), công việc tính toán cần được chia nhỏ và phân phối trên hàng ngàn, thậm chí hàng trăm ngàn chip TPU hoạt động song song. Runtime này được bộ phận Google DeepMind phát triển, nó khác với Pathways Architecture mà Google từng giới thiệu trước đây.

Đây được xem như mô hình thay thế cho Gemini 2.0 Flash cũng như một biến thể chuyên suy luận của nó là Gemini 2.0 Flash Thinking. Google chưa công bố chi tiết về Gemini 2.5 Flash và họ có hứa hẹn sẽ công bố sau, họ chỉ cho biết là Gemini 2.5 Flash sẽ sớm có mặt trên ứng dụng Gemini, Vertex AI cũng như Google AI Studio.

Đây là mô hình hiện ở giai đoạn preview, có trên Vertex AI dành cho doanh nghiệp. Mô hình này cho phép người dùng tạo ra âm thanh có chất lượng cao, đa thể loại, hỗ trợ sản xuất nhạc nền dành cho video hay podcast

Mục đích của Google với Lyria là giúp rút ngắn thời gian sản xuất, giảm chi phí dành cho doanh nghiệp hay các studio.

Tại Cloud Next, Google cũng giới thiệu thêm tính năng cho Veo 2, mô hình tạo cũng như chỉnh sửa video. Veo 2 bây giờ có thêm tính năng chỉnh sửa video chuyên nghiệp như Inpainting là xóa hình nền, logo hoặc yếu tố gây xao nhãng khỏi video, khiến chúng biến mất hoàn toàn qua từng khung hình hay Outpainting, mở rộng khung hình video, chuyển đổi định dạng truyền thống sang tối ưu cho web và di động.

Mô hình Imagen 3 cũng được Google cải thiện về khả năng xoá vật thể trong ảnh.

Google. Nguồn:tinhte.vn/thread/google-cloud-next-2025-tpu-the-he-7-ironwood-gemini-2-5-flash-mo-hinh-lyria-tao-nhac-tu-van-ban.3996249/